Retrieval Augmented Generation – RAG: Generative künstliche Intelligenz-Lösungen mit Unternehmensdaten anreichern

April 19, 2024 | Techartikel | Autor: Andreas Schmid & Dr. Matthias Sommer

„Cheaper, faster, better. […] RAG is like pointing a large language model in the right direction and giving it more specified guidance.“ [1] – Gabriel Skelton, Head of Artificial Intelligence Solutions & LinkedIn Top AI Voice

Generative künstliche Intelligenz (GenKI) ist eine Form der künstlichen Intelligenz (KI), die mithilfe von Algorithmen des tiefen Lernens neue Inhalte wie Texte, Bilder, Code oder Videos generieren kann [2]. Mit dieser Fähigkeit kann GenKI helfen, Empfehlungssysteme, Suchmaschinen oder Dialogsysteme zu optimieren. Zudem können GenKI-Systeme dazu beitragen, Routineaufgaben zu automatisieren oder Ideen für neue Produktdesigns zu generieren. Zu den momentan bekanntesten Vertretern gehören zum Beispiel ChatGPT und DALL-E von OpenAI, GitHub Copilot oder Gemini von Google [3].

Trotz der vielversprechenden Einsatzmöglichkeiten von GenKI existieren zahlreiche Herausforderungen zur erfolgreichen Implementierung eigener Lösungen. Dieser Artikel führt in die GenKI, ihre Problemstellungen und den Lösungsansatz Retrieval Augmented Generation (RAG) ein.

1. EINORDNUNG IN DAS FELD DER KÜNSTLICHEN INTELLIGENZ

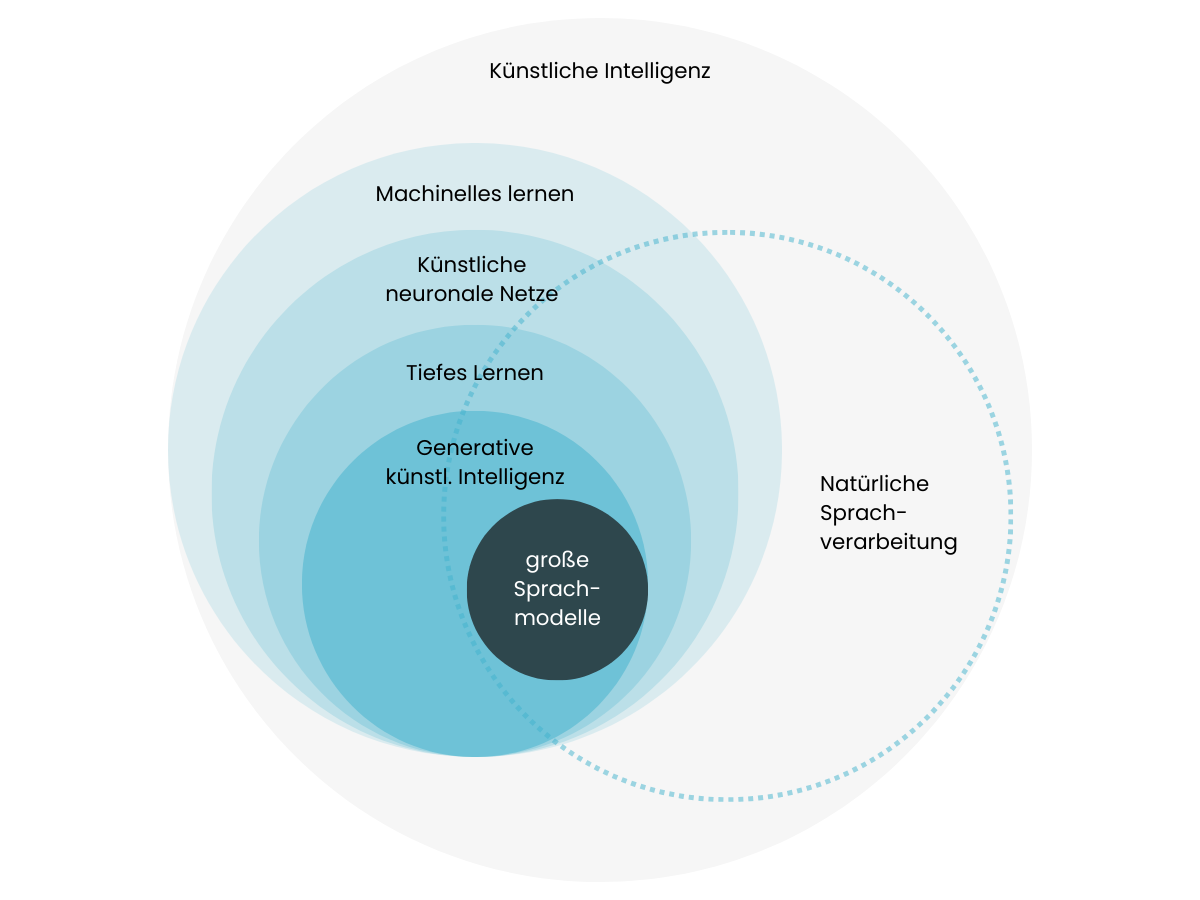

GenKI-Modelle sind ein Teilbereich des tiefen Lernens. Zu den bekanntesten Modellen zählen große Sprachmodelle (engl. large language models – LLMs). LLMs sind eine moderne Form von Sprachmodellen, die aus aktuellen Forschungen in den Bereichen natürliche Sprachverarbeitung, tiefes Lernen und GenKI resultieren [4]. Abbildung 1 veranschaulicht die Einordnung von GenKI und LLMs.

Abbildung 1: Einordnung GenKI und LLMs

2. FUNKTIONSWEISE

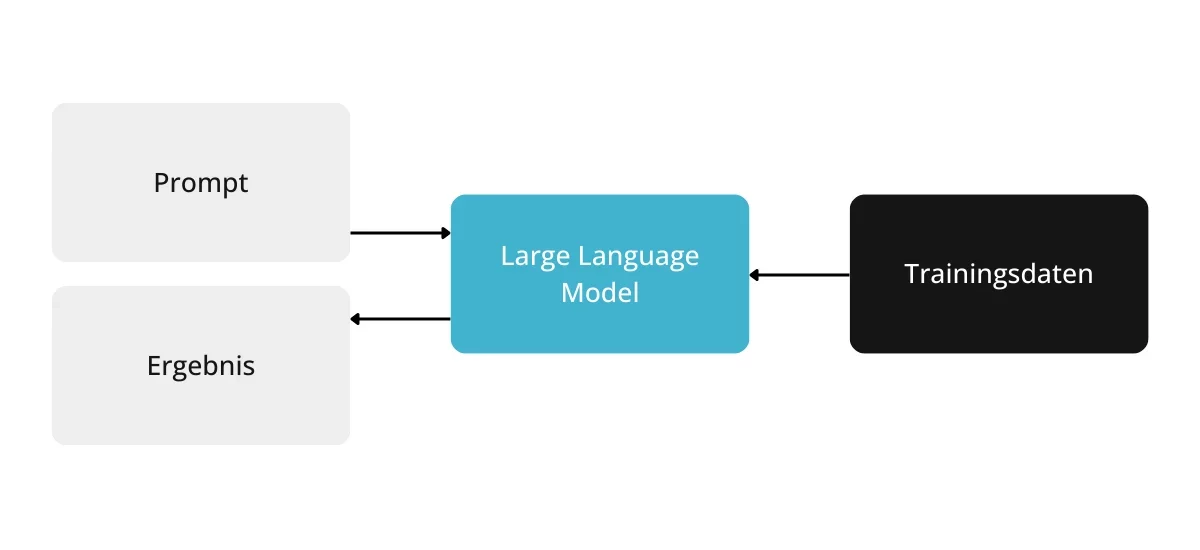

Im Wesentlichen basieren GenKI-Modelle wie LLMs auf statistischen Zusammenhängen, die aus dem Trainingsmaterial erhoben werden. Dabei werden die Eingaben des Benutzers analysiert, in computerlesbare Form gebracht, mithilfe eines künstlichen neuronalen Netzes weiterverarbeitet und das Ergebnis schlussendlich wieder als Text ausgegeben [4]. Die Funktionsweise eines LLMs ist in Abbildung 2 dargestellt.

Abbildung 2: Funktionsweise eines LLMs

LLMs werden auf riesigen Datenmengen trainiert und verwenden Milliarden an Parametern, um Aufgaben wie die Beantwortung von Fragen oder die Generierung von Bildern und Videos zu erledigen. Hierfür nimmt das LLM die natürlichsprachliche Benutzereingabe in Form eines Prompts entgegen und erstellt auf Basis seiner Architektur sowie der vortrainierten Wissensbasis eine Ausgabe, welche dem Benutzer als Ergebnis angezeigt werden kann [5].

3. HERAUSFORDERUNGEN

Trotz der beeindruckenden Fähigkeiten stoßen GenKI und LLMs an ihre Grenzen. So fehlt es ihnen an detailliertem Domänenwissen, da diese auf einem breiten Spektrum an Daten, meist ohne gezielte Fokussierung auf spezifische Domänen, trainiert werden. Darüber hinaus verfügen sie nur über Wissen bis zu einem bestimmten Stichtag und können keine Aussagen über aktuelle Daten liefern. Diese Einschränkung ist mit dem einmaligen Trainingsprozess verbunden, der äußerst zeit-, kosten- und rechenintensiv ist. Des Weiteren besitzen LLMs kein Know-how über Unternehmensinterna, wobei das hierfür notwendige Training für die meisten Unternehmen viel zu kostspielig ist. Zusätzlich neigen LLMs in ihren Ausgaben zu Halluzinationen. Unter Halluzinationen versteht man die Generierung von Ausgaben, die nicht der Realität entsprechen. Diese resultieren aus der Tatsache, dass LLMs ihre Ausgaben auf Basis der Wahrscheinlichkeiten für das nächste Wort erstellen, ohne dabei den Wahrheitsgehalt zu berücksichtigen [6]. So kann eine Aussage sehr wahrscheinlich, jedoch trotzdem falsch sein.

4. RETRIEVAL AUGMENTED GENERATION ALS LÖSUNGSANSATZ

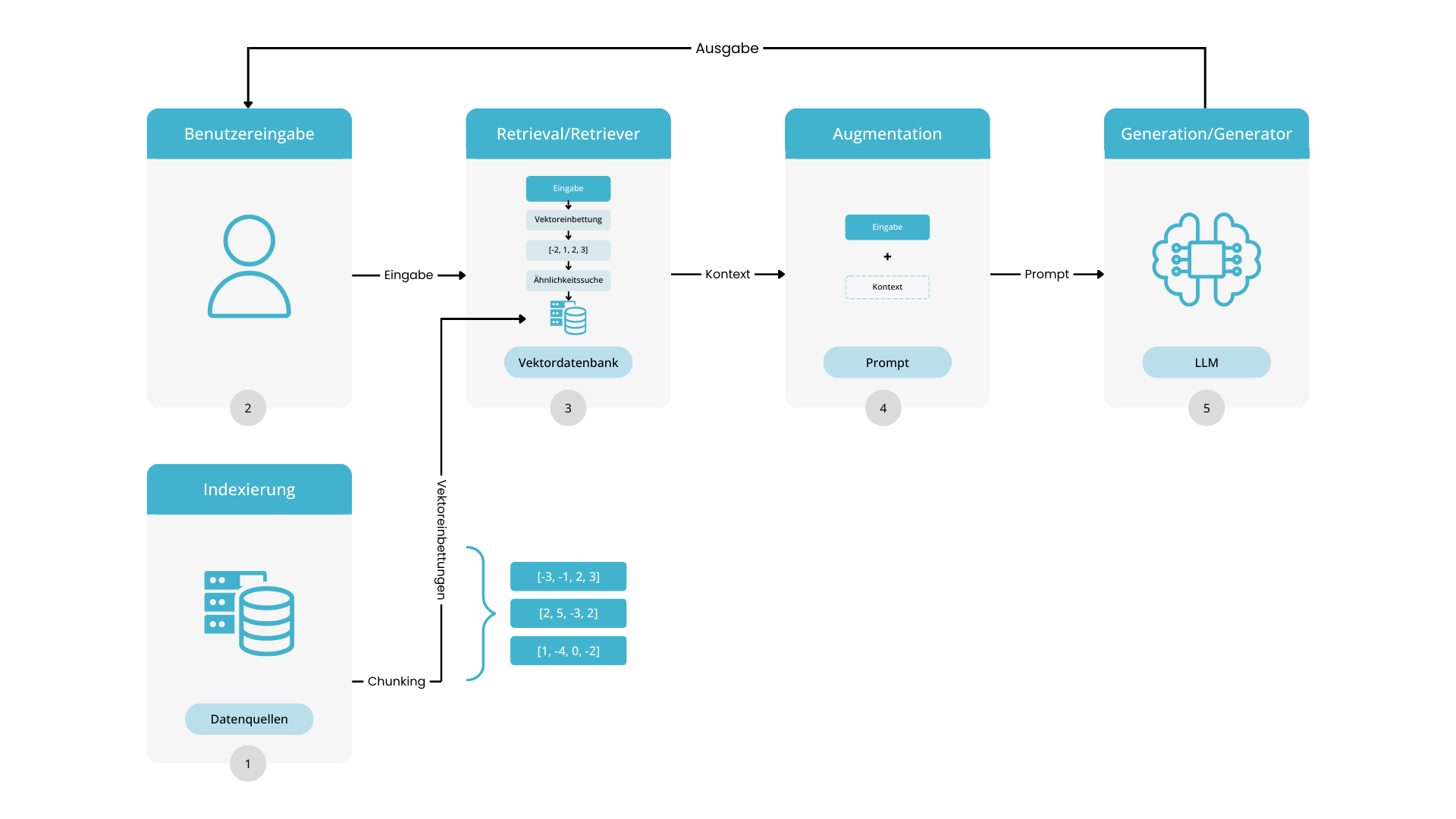

Um die genannten Herausforderungen zu überwinden, beschäftigen sich neue Ansätze mit der Kombination von LLMs mit aktuellen, proprietären und domänenspezifischen Daten. In Bezug auf Geschäftsprozesse können das etwa Dokumente, Handbücher, Webseiteninhalte oder andere Informationsquellen sein. Ein Architekturkonzept, dass die Integration der eigenen Daten in GenKI-Lösungen erlaubt, ist RAG. RAG ermöglicht dies durch das Abrufen von relevanten Informationen aus zusätzlichen Datenquellen, die anschließend dem LLM zur Verfügung gestellt werden. Auf diese Weise optimiert RAG die Ausgabe, ohne das LLM neu trainieren zu müssen [2].

RAG ist ein kostengünstiger Ansatz und macht LLMs im geschäftlichen Umfeld nutzbarer. Die von RAG genutzten Daten können aus APIs, Datenbanken oder Dokumenten stammen. Dabei muss jedoch darauf geachtet werden, dass der Datenschutz beachtet wird und keine personenbezogenen Daten oder geistiges Eigentum mit einbezogen werden.

5. ARCHITEKTUR UND PROZESS

Um zu verstehen, wie RAG im Detail funktioniert, führt Abbildung 3 in den RAG-Prozess und die zugrundeliegende Architektur ein.

Abbildung 3: RAG-Architektur und Prozess

SCHRITT 1: INDEXIERUNG

SCHRITT 2: BENUTZEREINGABE

SCHRITT 3: RETRIEVAL

SCHRITT 4: AUGMENTATION

SCHRITT 5: GENERATION

6. VORTEILE

Die Integration von RAG in GenKI-Lösungen ist mit einer Reihe von Vorteilen verbunden.

| Vorteil | Beschreibung |

| Aktualisierung der Wissensbasis | Die Vektordatenbank kann jederzeit um neue Inhalte erweitert werden, wodurch der Zugriff zu aktuellen Informationen gewährleistet wird. |

| Transparenz | Antworten können zu den Datenquellen zurückverfolgt werden, wodurch eine hohe Transparenz gegeben ist. |

| Vermeidung von Halluzinationen | Da Antworten ausschließlich aus den eigenen Dokumenten generiert werden, sind Halluzinationen seltener. Zudem kann über vordefinierte Prompts sichergestellt werden, dass das LLM standardisierte Antworten liefert, wenn keine Informationen gefunden werden. |

| Kostengünstige Alternative | Da das zugrundeliegende LLM nicht neu trainiert werden muss, sobald neue Daten hinzugefügt werden, können erhebliche Kosten eingespart werden. |

7. FAZIT UND AUSBLICK

RAG ist ein vielversprechender Ansatz zur Integration von Unternehmensdaten in GenKI-Lösungen. Zur Implementierung von RAG bieten sich zahlreiche Möglichkeiten an, darunter beispielsweise standardisierte Cloud-Lösungen von Microsoft Azure oder Amazon Web Services, Individuallösungen mithilfe von Open-Source-Frameworks wie LangChain und Semantic Kernel oder eine Kombination aus den genannten Technologien [7,8].

Die aktuelle Forschung im Bereich der GenKI geht momentan wieder in Richtung kleinere und auf spezifische Anwendungsfälle spezialisierte Sprachmodelle, beispielsweise Code Llama für Quellcodegenerierung [9]. Diese sogenannten kleinen Sprachmodelle (engl. small language models, SLMs) weisen dank Innovationen in Bereichen wie verbesserter Datenaufbereitung und Modellskalierung ähnlich gute Resultate wie deutlich größere LLMs auf [10]. Hier zeigt sich erneut, dass die Qualität der einbezogenen Daten eine entscheidende Rolle spielt.

- Die Integration von Unternehmensdaten in GenKI-Lösungen kann mit RAG kostengünstig umgesetzt werden.

- RAG kann bestehende Geschäftsprozesse optimieren und zu Effizienzsteigerung führen.

- Der Erfolg von RAG-Lösungen hängt maßgeblich von der Qualität der Daten ab.

- Die Qualität der mittels RAG erzeugten Ausgaben sollte überprüft und gemessen werden.

QUELLEN:

- What is RAG and how will it impact your adoption of AI?

- Zhao P., Zhang H., Yu Q., Wang Z., Fu F., Yang L., Zhang W., Cui B., (2024). Retrieval-Augmented Generation for AI-Generated Content: A Survey

- Top 10 Generative AI Tools You Should Know for 2024

- Amaratunga T., (2023). Understanding Large Language Models

- Large language models: The basics and their applications

- Was ist Retrieval Augmented Generation?

- Retrieval Augmented Generation (RAG) in Azure KI Search

- Harnessing the power of Large Language Models: A comparative overview of LangChain, Semantic Kernel, AutoGen and more

- Introducing Code Llama, a state–of–the-art large language model for coding

- Phi-2: The surprising power of small language models